近年来互联网的高速发展引领人类进入了一个信息量爆炸性增长的时代。每个人的生活中都充满了结构化和非结构化的数据。随着人类生活全面向互联网转移,大数据时代将会不可避免的到来!

作为全球互联网的前沿概念matlab高维数据可视化,大数据主要包括两方面特征:一方面整个社会的信息量急剧增长,另一方面个人可获取的信息也呈指数增长。从科技发展的角度来看,“大数据”是“数据化”趋势下的必然产物!并且随着这一趋势的不断深入,在不远的将来我们将身处于一个“一切都被记录,一切都被数字化”的时代。

在这种背景下,对大数据的有效存储以及良好地分析利用变的越来越急迫。而数据分析能力的高低决定了大数据中价值发现过程的好坏与成败。本文以大数据时代的数据分析为主题,简明的阐述了国内大数据分析的发展现状、大数据的分析模式以及主要的分析技术、大数据时代数据分析的几个核心概念等相关问题。

1.国内大数据分析的发展现状

数据分析是数据处理流程的核心,因为数据中所蕴藏的价值就产生于分析的过程。所谓“大数据分析”,其和以往数据分析的最重要的差别在于数据量急剧增长。由于数据量的增长,使得对于数据的存储、查询以及分析的要求迅速提高。从实际操作的角度看,“大数据分析”需要通过对原始数据进行分析来探究一种模式,寻找导致现实情况的根源因素,通过建立模型与预测来进行优化,以实现社会运行中各个领域的持续改善与创新。

虽然近两年来“大数据”的概念越来越多的被媒体以及行业提及,但“大数据分析”在国内的发展却仍处于初期阶段。

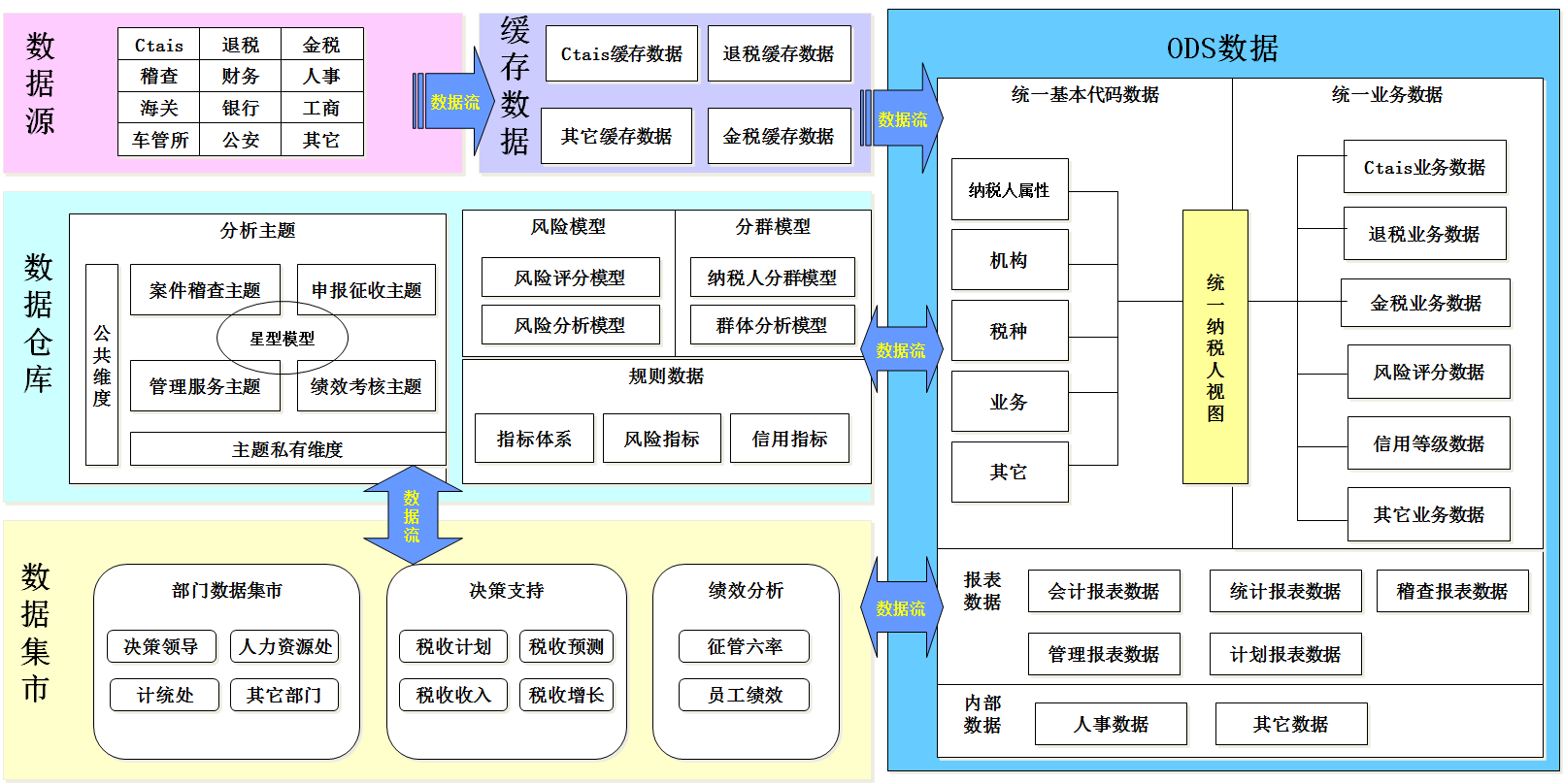

从行业实践的角度看,只有少数几个行业的部分企业,能够对大数据进行基本分析和运用,并在业务决策中以数据分析结果为依据。这些行业主要集中在银行与保险,电信与电商等领域。以银行业为例,目前大型国有银行在其主营业务中均引入了数据分析,但深度尚可,广度不够,尚未扩充到运营管理的所有领域;而中小银行在数据分析方面的人员与能力建设尚处于起步阶段。对于支撑起我国庞大国民生产总值的建筑业、制造业以及贸易行业,其数据分析应用远远没有进入规模化发展阶段,这些行业在IT方向的开支主要集中在公司日常的流程化管理领域。

从技术发展的角度看,一些已经较为成熟的数据分析处理技术,例如商业智能技术和数据挖掘技术,已经在多个行业领域里得到广泛和深入的应用。最典型的就是电商行业,运用这些技术对行业数据进行分析,对提高行业的整体运行效率以及增加行业利润都起到了极大的推动作用。但对于像Hadoop、非结构化数据库、数据可视化工具以及个性化推荐引擎这样的新技术,其较高的技术门槛和高昂的运营维护成本使得国内只有少数企业能够将其运用到深入分析行业数据中。

从数据来源的角度看,在能够实现数据化运营的企业中,绝大多数仅仅完成了依靠企业自身所产生的数据解决自身所面临的问题,并且是依据问题来收集所需要的数据。而仅有极少数互联网企业能够发挥出大数据分析的真正价值:同时运用企业外部和内部的数据来解决企业自身的问题,通过数据分析预测可能出现的问题,并依据数据分析的结果进行商业决策。在一定程度上实现了由数据化运营向运营数据的转变。

2.大数据的主要分析模式与技术

2.1 大数据的主要分析模式

大数据时代所分析的数据的最主要特征是“多源异构”,其分析过程是逐层抽象、降维、概括和解读的过程。从数据采集的源头进行划分,可将大数据时代分析处理的数据对象划分为以下几个类别:

(1)各网页中用户的浏览次数、点击率,各种社交网站、动态网站网页内容信息的变化,搜索引擎中关键词的搜索量、网络实时监控数据等互联网数据。

(2)可以用于分析用户行为、对系统的操作、以及系统运行状态的日志数据。

(3)在通信领域中的各种信号、信令数据,用户的个人信息以及通话位置、时长等数据。

(4)国民经济中各领域、各行业的统计分析数据。

对于这些数量庞大的,来自不同源头的非结构化数据。其分析模式的特点如下:对于互联网产生的数据,其最主要的应用是建立搜索引擎,通过搜索引擎进行数据检索、处理。随着技术的不断发展,个性化推荐引擎以及大数据分析引擎的问世能够更加高效的在海量数据中分析得出更有价值的信息;对于日志数据,可对用户点击浏览的行为日志和系统运行行为日志进行分析。使得系统能够根据实际情况产生出更加智能的结果。日志数据与网页数据的分析处理模式较为类似,都是通过细致分析从而探寻出数据中蕴藏的价值。这种数据分析处理模式称为“离线批处理模式”;对于通信领域的数据分析,分析决策人员会对经过细致分析的数据进行统计归纳和查询,并且在最短的时间内获得最有价值的信息。以此来确保系统的交互性并最大限度地提升用户体验。这种数据分析处理模式称为“查询式分析”模式;对于互联网以及国民经济中重要行业的数据进行实时监控,这种模式称为“实时数据分析处理“模式。

以上为依据时间特征划分的数据分析模式。而实现这些分析模式的主要方法有:分类、回归分析、聚类、关联规则、神经网络、WEB数据挖掘等。

2.2 大数据的主要分析技术

要想从急剧增长的数据资源中挖掘分析出有价值的信息,需要先进的分析技术作支撑。从宏观上看,大数据分析技术发展所面临的问题均包含三个主要特征:

(1)数据量庞大并以惊人的速度增长;

(2)数据种类与结构多样化,并以半结构化和非结构化的数据为主;

(3)需要具备及时快速的分析速度,即实时分析。这些特征使得传统的数据分析技术无法满足要求,更加先进的数据分析平台才是大数据时代更好的选择。

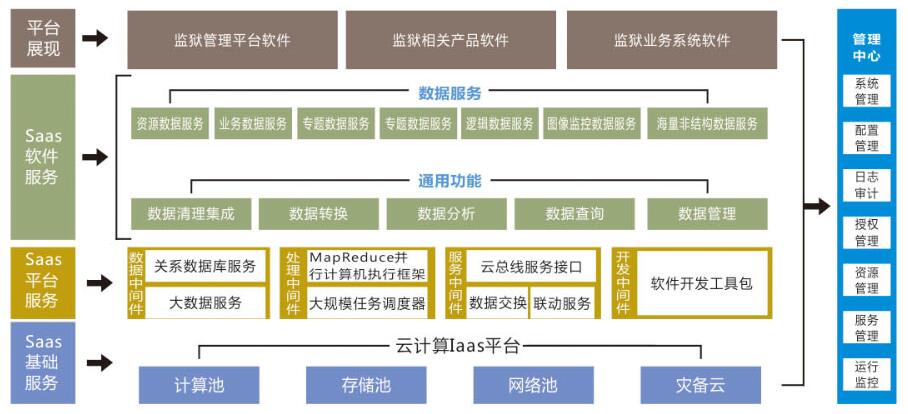

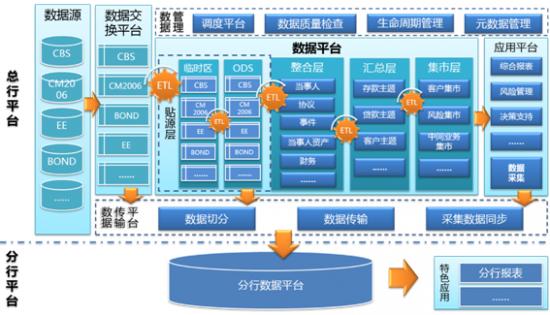

为了有效应对大数据时代数据分析问题的三个主要特征以及满足大数据分析的基本需求,当前以及未来一段时期内将主要通过分布式数据库或者分布式计算集群来对存储于其内的海量数据进行由浅入深的分析和分类汇总。例如,为满足实时分析的需求通常会采用Qracle的Exadata 和EMC的GreenPlum。而目前分析处理大数据的应用最广泛的核心技术为Hadoop。

Hadoop是由Apache基金会所开发的一个基于Java的分布式数据处理和分析的软件基础架构。在这种架构下,用户可以在不了解分布式底层细节的情况下,开发分布式程序。Hadoop能够将数量庞大的数据分解成规模较小、易访问的数据集并发送到多台服务器上进行分析,以此获得高效的分析速率。该架构主要由文件系统以及数据处理两部分功能模块组成。

3.大数据分析的几个核心概念

3.1 K―平均算法

K―平均算法是一种得到广泛应用的基于划分的聚类算法。其把M个对象分为N个簇,使得每个簇内具有较高的相似度。

在应用该算法进行数据分析时,首先应输入包含M个对象的数据集A以及簇的数目N。从A中任意选择N个对象作为初始簇中心并且不断重复,随后计算出簇中对象的均值,将每个对象分配到最相似的簇并且不断更新簇均值,最后计算准则函数直到其不再发生变化为止。因为该算法的复杂度大约是0(nkt),所以该算法在处理大数据集时是相对可伸缩的和高效率的。

3.2 奇异值分解

假设A是一个m×n阶矩阵,其中的元素全部属于实数域或复数域。如此则存在一个分解使得A=U∑V*。其中U是m×m阶酉矩阵,Σ是半正定m×n阶对

来源【首席数据官】,更多内容/合作请关注「辉声辉语」公众号,送10G营销资料!

版权声明:本文内容来源互联网整理,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 jkhui22@126.com举报,一经查实,本站将立刻删除。