14年8月19日至20日,“2014中国国际大数据大会”在北京国宾酒店召开。以下为IBM中国开发中心信息管理软件部总经理朱辉演讲。

观点浓缩:

1、大数据这件事,如果说它有一个生命周期的话,我觉得它还没有超过它的婴儿期;

2、大数据的魅力不在于它大,而在于这么大的数据里可以产生越来越多以前没有的价值。

3、大数据并不光光是指新数据,在这个社会当中,最有价值的数据仍然是在企业内部本身几十年来已经累计下来的数据,也就是说在传统的数据管理核心系统当中产生出的,是仍然具有价值的,不一定是最大的数据,也不一定是最新潮的数据,但它一定是具有最大商业价值的数据。

4、我们现在都说数据是资源,确实是资源,谁掌握了数据、谁掌握了信息,那一定是站在竞争的高点。但问题是大数据应用场景 ppt,石油也是源,石油在没有被加工之前其实是没有用的,从沙特阿拉伯运出来的一桶一桶石油你一点儿用都没有,不小心倒出来了你洗都洗不掉,但经过处理之后会发挥非常大的价值,人类的打仗基本上都是为了它,信息是一个道理,没有经过加工的信息是一个资源,但是它没啥用。

5、我们认为目前为止是这五个领域:大数据的探索、360度全方位客户视图、运维及运营的分析、数据仓库能力的扩展和增强,以及安全和风险能力增强。

6、既不能丢失大数据给我们带来的全新机会,但是也不能被它过度的忽悠,还是要以科学的实事求是的精神来做。

7、目前还没有到完全指令性分析主导主业务决定的阶段,但指令性分析已经越来越成一个上升的趋势。

演讲原文及PPT对照:

朱辉:大家好!我来自IBM的中国研发中心,我叫朱辉,现在在带领大概500位工程师在北京上地中关村软件园,做所有IBM跟信息管理和大数据相关的产品。

我07年回国之后,08年就开始涉入大数据领域,开始搞Hadoop方面的工作,那时候我08年第一次在我下面成立了一个团队,就是搞Hadoop加速器的研发。

我今天来的目的是这样,我觉得大数据这件事其实有很多基本概念,我觉得我们已经过了那个点,大家对这个普教式的理解都已经有了,作为在信息管理这个领域搞了快20年的一个技术出身的人,我就代表IBM分享一下对这个事儿自己的一些看法。

首先申明一点,大数据这件事,如果说它有一个生命周期的话,我觉得它还没有超过它的婴儿期,所以在这当中很多想法和看法,都是不成熟的,所以如果在今天我这短短的20分钟里,能够提出一些略有价值的问题留给大家做思考,我觉得我们的任务就已经完成了。

这张图可能大家看过不同的版本,它其实主要讲的是大数据来自于哪里,说这个我跟大家分享一个故事,我08年刚开始成立一个小团队在做Hadoop研究的时候,我回我们硅谷实验室,大家可能也知道关系型数据库的发明就是来自于IBM,搞了30多年我们在硅谷那边有一帮大拿们,所谓的IBM院士大数据应用场景 ppt,他们的江湖地位不可动摇,所以我去请示一下给我们一些指导。当时我被来回颠倒,08年他们说你为什么考虑大数据?他们说大数据的问题自从有了数据库技术之后,从来就没有消失过,我们每年都在想办法解决数据越来越大的问题,为什么现在大数据又成了一个新的事儿了呢?这是08年的思维。

到了大概四五年前的时候,我觉得越来越多的人,开始愿意打听大数据这件事,到底大数据是什么,那个时候我们就开始讲大数据的非结构化数据的产生,结构化数据和非结构化数据的并存,每年的数据量增长,大概达到了什么样的量级,我们预估2020年大概数据量会达到什么样,这是大概四年前交谈的内容。

大概两年前,我觉得这个交谈也不太需要了,我们跟企业的CIO、CTO谈的时候他们已经知道了,两年前谈的是,非常好,总部领导也觉得很重要,跟我讲讲,从哪开始?弄点儿什么东西?

所以我觉得到了今天这个地步,尤其是我们今天谈的主题是智慧城市,我觉得我们有必要,一方面来看一下,我们目前对这件事情最新的一些理解是什么;第二,我们认为可落地的场景有哪些。

我觉得,社交媒体,尤其是大数据非结构化数据产生的来源,越来越多的感知设备或者感应器在产生越来越多的数据,这也不容置疑。而且,随着人而对数据处理能力进一步的了解,我们在每天都有很多很多人在想各种各样办法,说什么地方我还能放个感应器,从中获得更多的数据。但是千万不要忘了,我下面要说的可能是现在有一点点误区的地方,大数据并不光光是指新数据,在这个社会当中,最有价值的数据仍然是在企业内部本身几十年来已经累计下来的数据,也就是说在传统的数据管理核心系统当中产生出的,是仍然具有价值的,不一定是最大的数据,也不一定是最新潮的数据,但它一定是具有最大商业价值的数据。

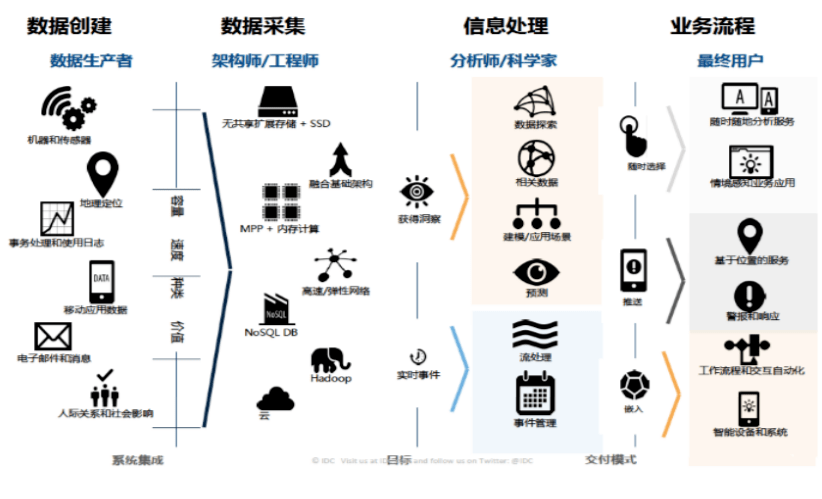

我们要解决的问题是什么呢?放在一个智慧城市概念考虑,一个城市里有很多很多硬件、环境、设备,通过感应器在产生很多数据,这部分数据我们要有。这个城市里面一定生活了很多很多人,人的行为模式,他的情绪表达,社交媒体上面的一些评论,这肯定是我们需要考虑的。运营这个城市,给这个城市里的人提供民生服务的企业,银行、电信、保险、公安,所有这些政府单位和企业所拥有的数据,也是一个智慧城市所需要关注的和所需要考虑的大数据的一部分。

所以,这三种数据来源之间怎么样共通?怎么样分享?怎么样把它整合到一个可进行分析的共有平台?这些是我们搞大数据技术需要花时间考虑和解决的问题。

这张图有很多很多数据,大其实不是好事,大数据的魅力不在于它大,而在于这么大的数据里可以产生越来越多以前没有的价值。

我上礼拜跟我的一个好朋友,在北京是中国一家商业银行的CIO吃饭,他就跟我说,我都是被你们这帮人害的,就你们这些人整天在外面忽悠大数据的事儿,研究搞的我们非常头痛。我说怎么头痛呢?他说现在行里面领导觉得数据是资源,什么数据都得留下来不能丢了,他说我的考核是预算,所以你们这帮人悠着点别再忽悠了,再忽悠我这工作没法干了。所以,数据大没问题,也是一个机遇,但怎么在其中淘出金子来,这是我们需要考虑的。

这张图也是非常标准的图,大家可能在很多场合也看到过,前面讲了大规模数据、多样化的数据,数据大但并不一定具有确定性,大浪淘沙,工作量很大,难度很高。

还有一个是速度,中文讲的非常好的潘总,讲到Hadoop不够快,但Hadoop是一个数据流,不会停,所以你永远都处理不完,我们一般对大数据的理解都是,我需要提高我的效率,需要提高更高的实时性,需要更快的拿到分析报表,能够影响到业务的决定,所有这些东西,在大、复杂、不确定的前提下,再加上一个速度,这使得大数据这件事情变成大家都看得到,但不容易落地,非常难成功的一件事,我觉得现在的状况基本处于这样的状况。

引用一下我非常崇拜的一位作家John naisbitt,他就是《大趋势》的作者,我们青少年的时候《大趋势》引领着我们对科学崇拜一本圣经般的书,他是第一位提出来把信息当做资源来看的人,我们第一次拥有了一个基于关键资源的经济体,就是以后的经济是围绕着信息运转的。

但是,更关键的问题是,他指出了这是一个自发生成的,靠近它没有关系,但不要淹没在其中,我觉得这是非常关键的,数据是源源不断的,但我们如果没有很好的办法,就整天讲大数据好象一定能成功,我觉得这是不对的,你没有这个处理能力就会被淹没在大数据当中,这是我们要小心的一个问题。

但是,上面讲的这句话也非常重要,跟它相对应的,我们现在都说数据是资源,确实是资源,谁掌握了数据、谁掌握了信息,那一定是站在竞争的高点。但问题是,石油也是源,石油在没有被加工之前其实是没有用的,从沙特阿拉伯运出来的一桶一桶石油你一点儿用都没有,不小心倒出来了你洗都洗不掉,但经过处理之后会发挥非常大的价值,人类的打仗基本上都是为了它,信息是一个道理,没有经过加工的信息是一个资源,但是它没啥用。

所以,我想我们现在对大数据最近几年的一个想法就是,怎么样把大数据当中的价值,能够从顶层设计上面定位好,怎么样从技术的手段上,能够处理好,能够产生价值,这是我们下一步做跟大数据相关的公司、企业以及个人都需要解决的一个问题。

讲到加工数据,就得介绍一下目前对数据的分析,所经历的几个关键时间段。

描述性分析,就是我们最为关心的报表。一堆历史数据,产生一个报表,年报、季报、月报、周报、日报,各种各样的报表,产生商用价值。预测性分析,通过数据挖掘,统计上面的一些算法,能够对基于历史的数据对将来数据的走向,做出一些预测和判断,这叫预测性分析。我觉得,我们现在基本上处在描述性分析,占据了数据处理的90%。预测性分析,可能占了整个数据处理的5%左右。剩下的5%,可能是刚刚进入一些指令性分析和认识性分析。预测性分析和指令性分析的区别在于,预测性分析我只告诉你,这只股票有可能会往下走,大盘有可能会跌,但是它不是个指令,指令型分析的结果是说,当某某股票到21块5的时候进,到22块6的时候出,这叫指令型分析的结果。我觉得,我们目前还没有到完全指令性分析主导主业务决定的阶段,但指令性分析已经越来越成一个上升的趋势。

最前沿的,也是我们IBM现在最关注的一个领域叫做认知性分析,认知性分析的宗旨就是,大数据还有性外一个特别重要的纬度,是我们不可以忽视的,就是数据已经超出了人可以处理的极限,我们现在世界上的数据,我们刚才说2003年前的数据我们现在两天就可以产生了,这是件非常好的事。但我想问的是,现在产生的数据有百分之多少是真正被人分析和处理的?比例非常非常少,数据已经超出了人类能够自我处理和分析的极限,这个趋势已经只会往越来越严重的方向发展,怎么办呢?我们需要有一个机器,这个机器有一个能力是自我学习、自我认知的,这是现在最热的一个领域。

我们IBM现在发布了一个产生叫沃森,就是自我认知的一个分析引擎,沃森一开始是来自美国一个相当百科知识竞赛上,我们把这个竞赛有史以来最厉害的两个冠军和这个机器一块比,问题通过人的自然语言来提,这个机器必须要通过听懂人的自然语言分析然后抢答,我们的机器以绝对的优势战胜。但那只是非常初级的阶段,我们两个星期前刚刚公布了一个新的最接近于人脑运作的芯片,这个芯片上面有54亿个晶体管,比英特尔现在的至强芯片要多10亿晶体管,这就是专门为自我学习、自我认知超级计算机做的,十几个这样的芯片就能达成一个超级计算机,然后它的能耗低于一个耳朵里戴的助听器电池的能耗,这是很厉害的,到目前为止,人类就没有发明过这样的处理能力。

但是,这个认知能力相当于什么呢?它只有100万个神经元,在这个小的芯片上,它相当于一只蜜蜂的能力,我们人类的脑子有1万亿倍于它,这就是差距。但是,芯片和CPU这个东西有个规律,一旦技术发生突破之后,它的前进步伐是非常快几何级的,所以我们有非常大的信心,这以后会成为我们感知、认知分析能力的一个支撑点。

我觉得在怎么样运用信息数据,怎么样能开发出适合智慧城市发展的应用上面,做了很多卓有成效的工作,我觉得非常钦佩。当然,总我们IBM的角度来讲,我们更多的是看,从信息到应用,中间这个历程,我们要解决的技术上的问题和平台级的技术,这是我们最感兴趣的。

信息需要有管制区、抓取区、实时分析区、探索着陆和成长区,数据仓库的及时分析。这个我就不细讲了,这本身就是一个很长的内容。

最后,关于产品技术上面我想讲,我们在讲大数据的时候,不能忘记云,我个人认为大数据的交付方式,一定得通过云。为什么呢?如果我们结合刚才我所提到的那几个我的观点的话,数据已经超出了人类能够处理的极限,数据的难度、复杂性,需要有极高的技术支撑来做。我个人认为,真正能够提供大数据分析能力的公司,往后走,会越来越集中。因为你想,我们同时还说信息是资源,资源一定会被抢夺,资源一定不会被免费的放持续,拥有资源的人就想在资源上赚钱。所以我个人认为,拥有信息的人,他一定要成为提供大数据服务价值交付的人,这是开门做生意的思维。这种交付,受益者是大众,是很多中小型公司,包括我们老百姓,我们老百姓不可能去买一套系统,只有云的交付方式才能让我以一个承受得起的价格,来享受世界上最领先的数据分析能力。

讲到这儿我又要提一个问题,我经常被邀请去参观各种各样的园区,我最远曾经跑到过吉林白城,我听都没听过的一个地方,不过非常漂亮,农产品很好,很绿色,他们造了一个大数据中心让我去看,我看了,非常漂亮,几十层楼高的大楼。我第一个问题就是,你有数据吗?还没有,你有应用吗?应用也不多,主要靠三大运营商在他们的分公司,把他们的应用放在上面。所以我一直在思考一个问题,现在中国有各种各样的大数据园区,这个区那个区,他们的信息从哪来?他们的应用从哪来?为什么信息要放到那去?我觉得这都是搞智慧城市,尤其是园区规划的领导和企业,需要考虑的一个问题。

我再举一个更极端一点的例子,如果我今天是某某大银行,我把一个灾备中心放在了你的园区里面,我有一个备份在你园区里面,这信息是你的吗?是他的还是你的?如果不是你的,你能在上面跑应用吗?你能分析它吗?你能享用这个信息带给你的价值吗?好象也不能。那它怎么就能跟你的智慧城市搭上边呢?它怎么就能贡献到你智慧城市呢?有没有关系?有,这个关系就是它是个绿色经济,这是有关系的。但是,你说这个数据有没有对你这个智慧城市产生直接的影响?那要看这个数据你能不能用,能够产生什么价值?所以,诸有此类的问题我觉得都是把大数据在现在,尤其是在中国,需要进行比较深层次,或者冷静思考的问题。

时间关系,我直接跳到我认为比较重要的剩下两个观点:

我们总结出来,现在在全球范围内,我今天引用的例子基本上都是全球范围内的,因为我想借这个机会给大家一些国外的借鉴。大数据被运用的最多的场景,我们认为目前为止是这五个领域:大数据的探索、360度全方位客户视图、运维及运营的分析、数据仓库能力的扩展和增强,以及安全和风险能力增强。

这个比较有意思,大数据的最大应用场景是大数据探索。这是什么意思呢?这个意思是说,其实现在大数据这件事,最大的一个挑战是找到实实在在的,真正能产生价值的能落地的应用,也就是说我前面开玩笑的说,老总们总是问我,预算不是问题,其实这体现的是我能干嘛,这恰恰是现在大数据的应用场景当中最多要探索的,这个探索是一个过程,是从初级的一种认识慢慢开始的。

我举个例子,我们IBM从1993年开始,作为大满贯的四大网球赛事技术合作伙伴,我们当时93年刚开始做的时候就从一件事开始,通过感应技术和高速摄像技术,来判断发球的速度,你们看网球都有120公里、90公里,我们就是从这个开始,然后从93年我们开始收集跟网球相关的数据。到2005年开始,我们对数据跟赛事之间关系有了比较深刻的理解之后,我们开始大规模收集,05-12年这八年我们在四个大满贯的赛事,我们一共收集了1800多场比赛,每场比赛收集4100万的数据,各种各样的数据点,感应器、高速摄像机上面的、视频的。数据越来越多之后,我们有一批 统计学家和数学家,分析其中有什么关系?还真发现了,最后我们做了一个软件叫SlamTracker,最开始是为了提升观众看网球赛的体验,给解说员提供一些基于大数据分析的结果。但是,现在它的最大应用者是教练和运动员本身,比如说我们发现一些什么东西呢?比如说李娜,我们发现李娜在四大赛事当中,当他跟对手比赛进入拉锯战的时候,当他超过20拍,她的得分率就开始下降,每增加10拍她的得分率会下降一个几何级,等到一定的拍数之后她几乎就不得分,这是个非常奇怪的现象。后来我们就看,这个统计稳定性在李娜身上特别明显。结果后来我们再去看更多数据,发现中国运动员身上都很明显。

后来我就去请教一些网球专业教练,李娜后来那个教练就跟我谈,中国运动员的基础训练特别特别扎实,网球运动员他们从小就是两三个小时来回拉球,从小到大已经形成了脑子反应的机制,当她进入拉回拉的时候不会变,你们看到乒乓球运动员的热身吗?后来你会感觉到它像是一个机械臂,身体的摆动是自然反应不是他脑袋的决定,也就是说中国运动员的扎实训练,使得他一进入20拍之后就进入了另外一个状态,她脑子不做太多的思考和决定,这时候就不会变线和长短球结合,就进入了一种打不过别人的状态。

另外一个有意思的数据,去年的法网最后决赛的时候,小威廉姆斯打沙拉波娃,当时我们算出,发球方第一个球过来的得分率,小威廉姆斯要赢沙拉波娃的话必须超过36%,而沙拉波娃要赢小威廉姆斯的话要超过28%就够了,当他没有达到这个得分率的时候,她整场比赛的赢率就会以一个规律下降。

我们93年的时候只做一件事,我们只想收集每个运动员发球的速度,只有那一个点,我们到05年只认识到好象应该收集这些数据,但不知道应该得到什么,2

来源【首席数据官】,更多内容/合作请关注「辉声辉语」公众号,送10G营销资料!

版权声明:本文内容来源互联网整理,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 jkhui22@126.com举报,一经查实,本站将立刻删除。